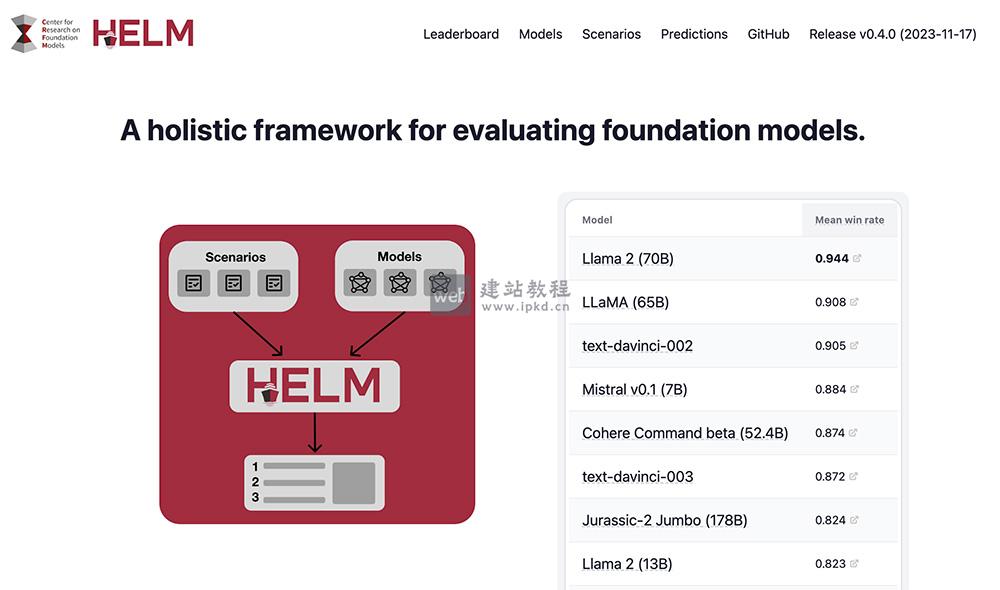

HELM,全称Holistic Evaluation of Language Models(语言模型整体评估),是斯坦福大学推出的大模型评测体系。其核心评测框架包含场景、适配、指标三大核心模块,每次评测需明确指定一个应用场景、一套模型适配提示,以及一项或多项评估指标。该体系当前以英语为主要评测语言,围绕准确率、不确定性/校准、鲁棒性、公平性、偏差、毒性、推断效率七大维度,对模型在问答、信息检索、文本分类等任务中的表现开展综合评测,为语言模型提供全面、系统的评估方案,助力研究人员与开发者深度理解并优化模型性能。

HELM核心功能:

1、多维度全面评估:

支持问答、文本分类、信息检索、文本生成、摘要等多类任务,覆盖准确率、鲁棒性、公平性、偏差、毒性、推断效率等核心指标,实现对语言模型性能的全方位诊断。

2、高可复现性与透明性:

基于标准化评估流程与配置文件,确保不同用户在同等条件下获得一致结果;评估代码支持查看与修改,兼顾评估过程的透明性与可定制化需求。

3、多模态任务支持:

突破纯文本任务局限,可对图像描述生成、视觉问答等多模态任务进行评测,全面衡量多模态模型的综合能力。

4、灵活自定义扩展:

提供完善的扩展机制,用户可根据研究或应用需求,自定义评估任务、适配策略与指标,满足个性化评测场景。

HELM应用场景:

1、语言模型性能评估:

全面评测模型在问答、文本分类等多类任务中的表现,帮助研发人员清晰定位模型的优势与短板。

2、模型优化与迭代:

依托详细的评估报告,锁定模型在特定任务或指标上的薄弱环节,为模型架构调整、训练策略优化提供数据支撑。

3、多模态模型评测:

针对图像-文本结合类任务,评估多模态模型的跨模态理解与生成能力,推动多模态技术落地。

4、公平性与偏差检测:

检测模型在性别、种族、文化等维度是否存在偏见,助力开发者打造更中立、公平的语言模型。

5、生成内容毒性检测:

识别模型输出的有害或不当内容,保障语言模型应用过程中的内容健康与安全性。

Ctrl-World模型使用入口,厘米级轨迹精度、0.986的策略评估一致性及0.93的深度准确性

TTT-Discover:斯坦福&英伟达联合推出,赋能AI科学发现的全新范式

PubMedQA:一个面向生物医学研究问题回答的专业数据集工具

H2O EvalGPT:H2O.ai推出的开源LLM大模型评估工具

LLMEval3:复旦大学NLP实验室推出的第三代中文大模型专业知识评测基准

上面是“HELM官网:斯坦福大学推出的语言模型整体评估体系”的全面内容,想了解更多关于 AI项目和框架 内容,请继续关注web建站教程。

当前网址:https://m.ipkd.cn/webs_28238.html

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

星火语伴APP最新版

星火语伴APP最新版 StreamRAG:ChatGPT可交互的视频搜索与流媒体代理工具,精准定位任意视频时刻

StreamRAG:ChatGPT可交互的视频搜索与流媒体代理工具,精准定位任意视频时刻 推荐一个免费、无版权的古典音乐下载的网站——Musopen

推荐一个免费、无版权的古典音乐下载的网站——Musopen 利用css3实现光效效果

利用css3实现光效效果 快速自动生成ppt,一款高效便捷的AI制作PPT工具

快速自动生成ppt,一款高效便捷的AI制作PPT工具