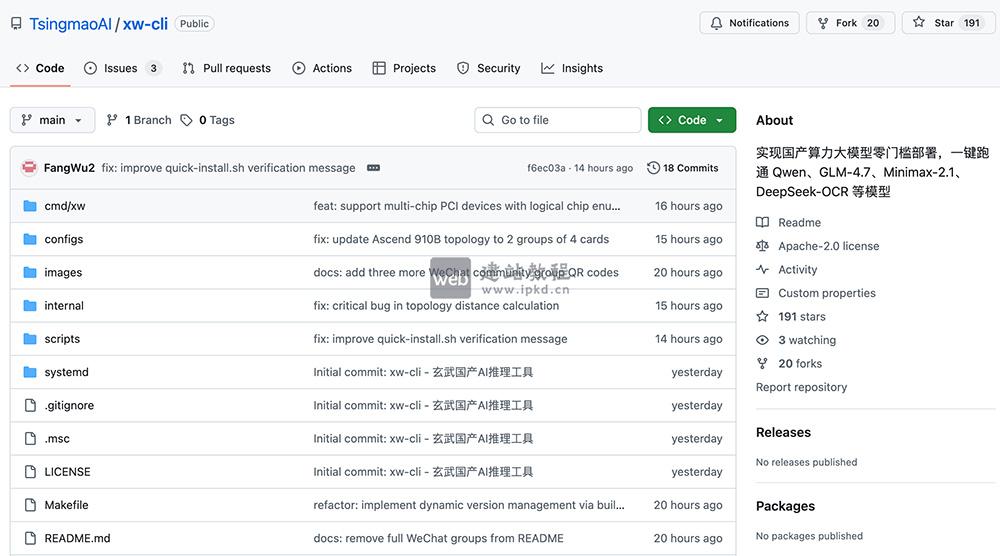

玄武CLI(xw-cli)是清昴智能开源的国产大模型专属部署工具,针对华为昇腾、沐曦、燧原等国产芯片深度优化,依托自动硬件检测、智能引擎调度能力,实现零复杂配置一键启动模型服务;兼容Ollama命令习惯与OpenAI API接口,支持DeepSeek、Qwen3等主流模型,5分钟即可完成部署,彻底解决国产算力「能用但不好用」的生态难题。

玄武CLI核心功能:

1、极简一键部署:

无需安装Python、配置复杂依赖,解压即可运行,最快1分钟启动生产级模型服务

2、智能硬件自动识别:

自动检测华为昇腾、沐曦、燧原等多款国产芯片型号,无需手动指定后端、调整参数

3、低成本模型管理:

兼容Ollama命令行操作习惯,xw pull拉取、xw run对话、xw ls查看本地模型,降低迁移学习成本

4、多引擎智能调度:

内置自研MLGuider推理引擎,兼容vLLM等第三方引擎,根据场景自动选择最优后端,平衡性能与兼容性

5、全量API兼容:

完整支持OpenAI API格式,LangChain、LlamaIndex及各类IDE插件,仅修改接口地址即可无缝接入

6、本地离线运行:

所有模型管理、推理任务均在本地完成,不依赖云端,满足金融、医疗等高隐私场景合规要求

7、生态联动赋能:

作为底层能力底座,可与Clawdbot等本地AI工具配合,为自动化任务、智能应用提供稳定模型支撑

玄武CLI技术原理:

1、异构算力抽象层:

构建统一硬件抽象接口,收敛华为CANN、摩尔线程MUSA等不同芯片架构差异,自动完成硬件识别、驱动匹配、环境初始化,向上层提供标准化模型服务接口,实现「零调试部署」

2、智能引擎路由:

内置自研MLGuider推理引擎,兼容vLLM等开源引擎,形成多引擎并存架构;模型加载阶段,根据芯片算力、模型架构(Dense/MoE)、量化精度等因素,自动选择最优执行路径

3、子进程隔离架构:

采用主进程+独立子进程设计,每个模型实例独立运行,单个任务崩溃/异常不影响主进程及其他模型运行,保障服务稳定性

4、模型-框架-算子联合优化:

针对国产芯片指令集、内存带宽特性,为FP8量化、MoE稀疏结构等新架构定制化开发算子,热门模型发布当日即可完成适配并达理想性能,解决国产算力「新模型水土不服」痛点

玄武CLI应用场景:

1、本地AI开发环境搭建:

开发者可在个人工作站/服务器快速部署DeepSeek、Qwen3等开源模型,无需高端NVIDIA显卡、Mac设备,直接激活手边国产算力资源,开展模型调试、应用开发

2、企业私有化部署:

适配金融、医疗、政务等数据高安全要求行业,实现模型全离线运行,杜绝敏感数据上云,同时降低长期API调用成本

3、智能体(Agent)基础设施:

作为Clawdbot等本地AI工具的底层模型底座,为自动化代码生成、Bug修复、语音交互等Agent应用,提供稳定、低延迟的推理能力支撑

4、国产算力生态验证与推广:

助力芯片厂商、集成商快速验证国产硬件的大模型运行效果,大幅降低开发者试用门槛,推动国产AI芯片从「能用」向「好用」转化,加速国产算力生态建设

Steerling-8B模型使用入口,80亿参数规模,在1.35万亿Token语料上训练完成

ComfyUI-LaoLi-Shadow安装插件入口,面向ComfyUI的底层性能加速插件

ComfyUI-RMBG v3.0.0插件使用入口,专业级图像分割与背景移除扩展

Minimalistic Comfy Wrapper WebUI模型GitHub使用入口

ComfyUI-OpenClaw安装使用步骤,安全优先为核心设计的ComfyUI自定义节点包

上面是“玄武CLI:清昴智能开源国产大模型部署工具,国产芯片专属一键部署”的全面内容,想了解更多关于 AI项目和框架 内容,请继续关注web建站教程。

当前网址:https://m.ipkd.cn/webs_30060.html

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

洞察AI工具:1分钟内生成详细的分析报告,覆盖多个行业领域

洞察AI工具:1分钟内生成详细的分析报告,覆盖多个行业领域 mysql中外键有什么用(主键是唯一的吗)

mysql中外键有什么用(主键是唯一的吗) 金山打字通官网入口,一个功能全针对性强的打字练习软件

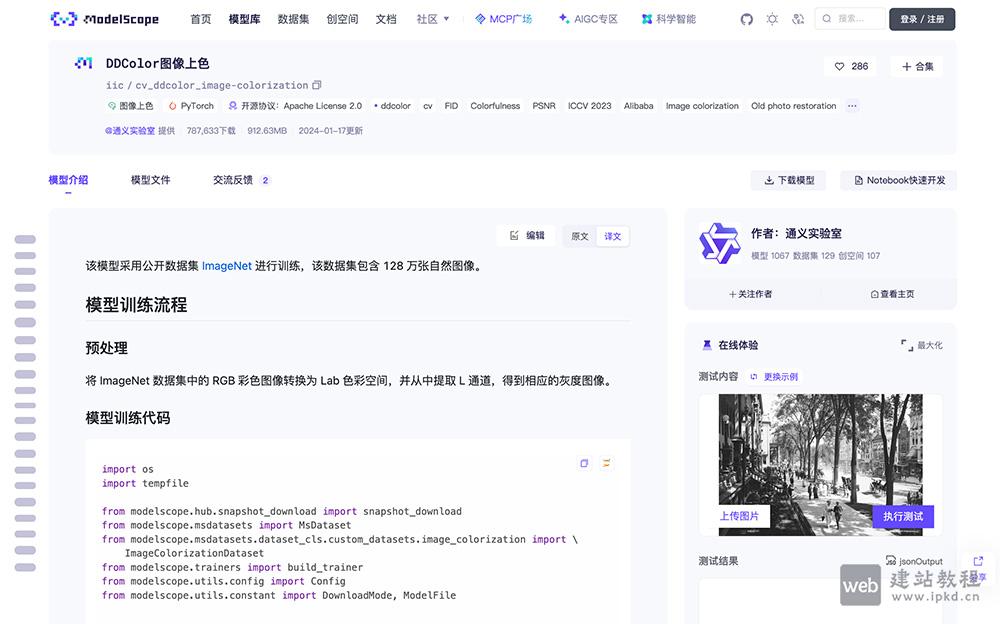

金山打字通官网入口,一个功能全针对性强的打字练习软件 DDColor:达摩院双解码器图像上色算法,让黑白画面自然焕彩

DDColor:达摩院双解码器图像上色算法,让黑白画面自然焕彩