Migician是由清华大学、北京交通大学和华中科技大学联合推出的一款多模态视觉定位模型,专门用于自由形式的多图像定位(Multi-Image Grounding, MIG)任务。该模型能够根据文本描述、图像或两者的组合,在多幅图像中精确定位相关的视觉区域。

Migician功能特点:

1、跨图像定位:

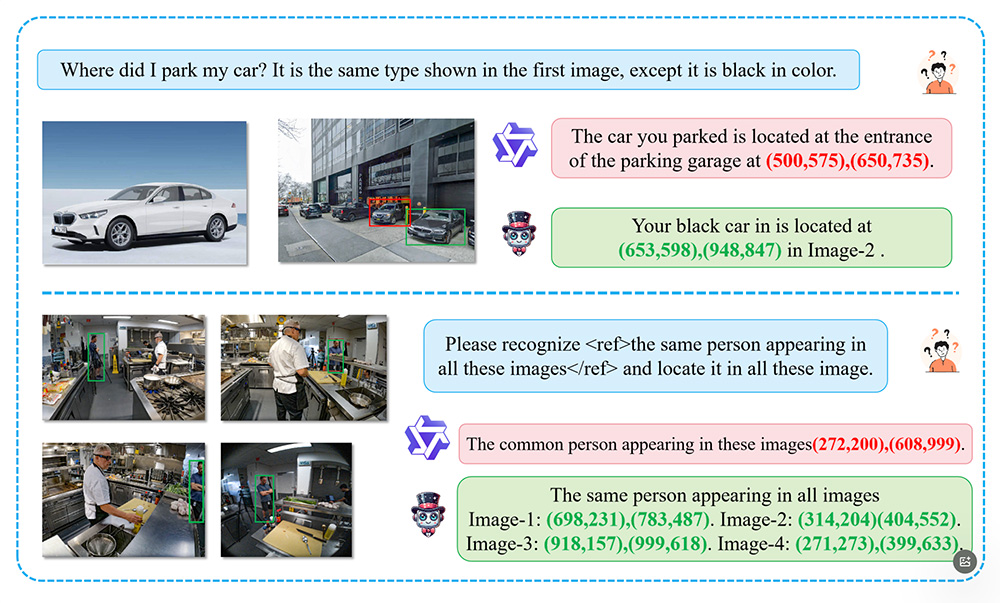

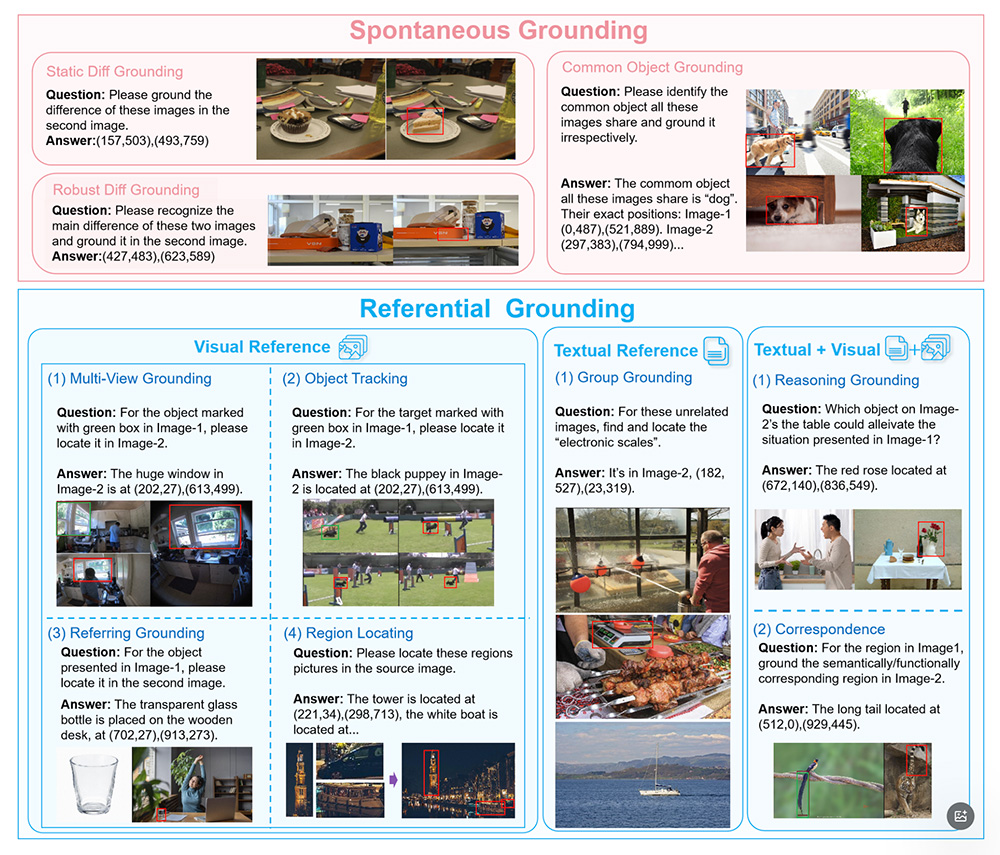

Migician能够在多幅图像中找到与查询相关的对象或区域,并给出其精确位置(如坐标框)。

2、灵活的输入形式:

支持多种输入形式,包括文本描述、图像或两者的组合。例如,用户可以输入“在图2中找到与图1相似的物体,但颜色不同”。

3、多任务支持:

Migician能够处理多种与多图像相关的任务,如对象跟踪、差异识别、共同对象定位等。

4、高效推理:

采用端到端的模型设计,直接在多图像场景中进行推理,避免了传统方法中多步推理带来的复杂性和错误传播问题。

5、大规模数据集支持:

Migician基于MGrounding-630k数据集进行训练,该数据集包含超过63万条多图像定位任务的数据,涵盖多种任务类型。

6、两阶段训练方法:

第一阶段:模型在多种多图像任务上进行训练,学习基本的多图像理解和定位能力。

第二阶段:基于自由形式的指令调优,提升模型在复杂查询下的定位能力。

7、多模态融合与推理:

结合视觉和语言模态的信息,Migician能够处理复杂的视觉语义信息,例如通过对比、相似性或功能关联来定位目标对象。

8、模型合并技术:

通过模型合并技术,将不同训练阶段的权重进行平均,优化整体性能。

Migician应用场景:

1、自动驾驶:快速定位车辆周围的目标(如行人、障碍物),支持多视角感知和动态目标跟踪。

2、安防监控:多摄像头联动识别异常行为或目标,分析人群聚集、快速移动等异常情况。

3、机器人交互:精准定位目标物体,支持机器人在复杂环境中完成抓取、导航等任务。

4、图像编辑:分析多幅图像内容,实现对象替换、删除或创意内容生成。

5、医疗影像:融合多模态影像,快速定位病变区域或异常组织,支持动态监测。

Migician相关网址:

1、Migician官网:https://migician-vg.github.io/

2、GitHub仓库:https://github.com/thunlp/Migician

3、HuggingFace模型库:https://huggingface.co/Michael4933/Migician

4、arXiv技术论文:https://arxiv.org/pdf/2501.05767

DreamID-Omni虚拟数字人模型,清华 × 字节跳动统一可控以人为中心音视频生成框架

Ctrl-World模型使用入口,厘米级轨迹精度、0.986的策略评估一致性及0.93的深度准确性

七牛云AI官网入口网址,支持Llama 3、GPT-OSS系列等开源大模型

AgentCPM-Report:清华大学等联合研发的本地化深度调研智能体

标签: AI大模型, 北京交通大学, 华中科技大学, 清华大学

上面是“Migician”的全面内容,想了解更多关于 AI应用 内容,请继续关注web建站教程。

当前网址:https://m.ipkd.cn/webs_17653.html

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

一套可免费商用的物品、情景元素插画库——IRA Design illustrations

一套可免费商用的物品、情景元素插画库——IRA Design illustrations 织梦cms如何实现用户点击后自动更新html

织梦cms如何实现用户点击后自动更新html 百度echarts X轴把小数点去掉

百度echarts X轴把小数点去掉 C知道:程序员的AI问答助手,高效解决技术难题

C知道:程序员的AI问答助手,高效解决技术难题 如何写出一篇高质量文章,写作方法介绍

如何写出一篇高质量文章,写作方法介绍