Meteora是由南京大学计算机科学与技术系研究团队开发的一种高效、可扩展的多任务嵌入框架,专门用于大型语言模型(LLM)。它通过混合专家(MoE)架构和低秩适配器(LoRA)技术,实现了高效的参数复用和任务切换,显著提升了大语言模型在复合任务中的性能。

Meteora功能特点:

1、多任务适配器集成:

Meteora将多个任务特定的LoRA适配器集成到一个基础LLM中,能够同时处理多种任务。

2、自主任务选择与切换:

无需人工指定任务意图,模型能够自主选择和切换任务,适应不同的输入。

3、高效推理:

提出MoE前向加速策略,通过自定义GPU核算子显著提升推理效率,同时保持低内存开销。

4、复合任务处理:

支持在一个推理过程中解决多个子任务,例如连续回答多个不同领域的问答,提升模型的灵活性和实用性。

5、扩展性:

支持多种LoRA适配器的集成,适用于不同任务和领域,扩展了LLM的应用场景。

6、混合专家架构:

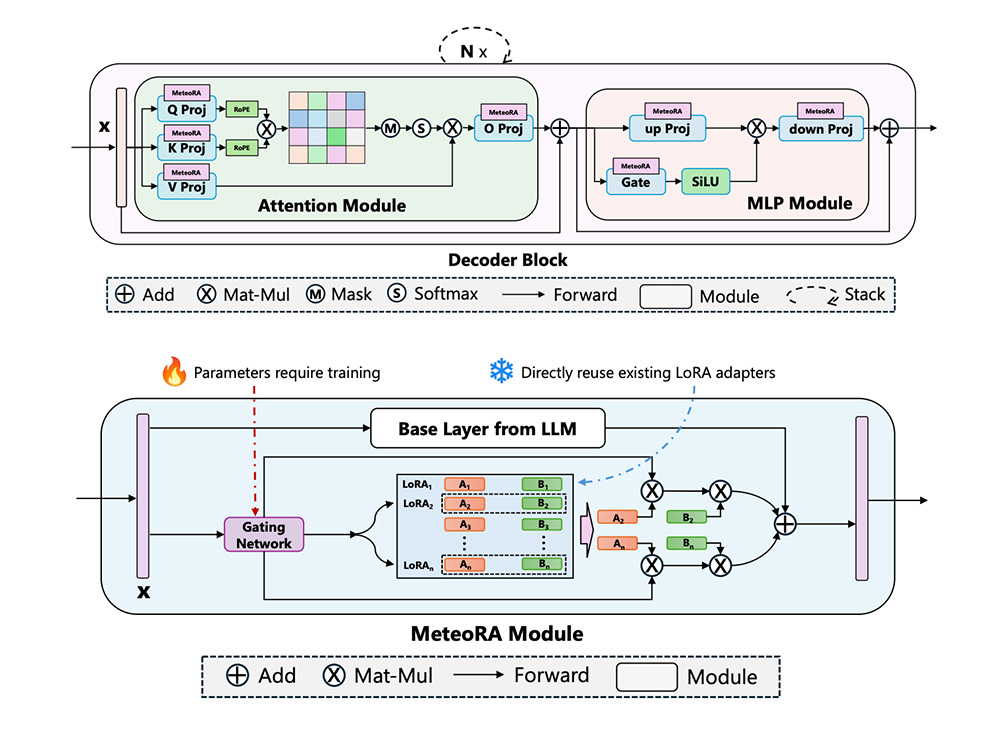

基于MoE架构,将多个LoRA适配器视为不同的“专家”,通过门控网络动态选择最适合当前输入的专家。

7、动态门控机制:

门控网络为每个输入动态分配权重,决定哪些LoRA适配器参与计算,支持灵活的任务切换和组合。

8、全模式集成:

将LoRA适配器嵌入到Transformer架构的所有线性层(包括注意力模块和MLP模块),更全面地利用不同任务的知识。

Meteora技术原理:

1、LoRA(Low-RankAdaptation):

LoRA是一种参数高效的微调方法,通过在LLM的线性层中注入低秩矩阵(A和B),仅更新这些矩阵以适应特定任务,而不改变基础模型的其他参数。

2、混合专家(MoE)架构:

MoE架构通过门控网络将输入动态分配给最相关的“专家”(LoRA适配器),从而提高模型的效率和性能。

DeepGen 1.0模型使用入口,浙江大学等联合推出的轻量级统一多模态模型,仅50亿参数

TeichAI官网使用入口,面向企业与开发者的一站式人工智能能力平台

Open Coding Agents:低成本、可复现的开源编程智能体,支持任意私有代码库

LongCat-Flash-Lite官网:美团新一代高效大语言模型

Neural4D:牛津&南大团队联合打造,人人能用的高效AI 3D建模平台

上面是“MeteoRA:南京大学开发的高效多任务嵌入框架,助力大语言模型性能飞跃”的全面内容,想了解更多关于 IT知识 内容,请继续关注web建站教程。

当前网址:https://m.ipkd.cn/webs_17952.html

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

帝国cms技巧之通过会员组的id来判断用户类型

帝国cms技巧之通过会员组的id来判断用户类型 米多客客服系统企业版

米多客客服系统企业版 FPSGO官网:专注于提供各种第一人称射击游戏信息和资源的平台

FPSGO官网:专注于提供各种第一人称射击游戏信息和资源的平台 HitPaw Univd:集视频转换、下载、编辑和压缩功能于一体的AI视频处理工具

HitPaw Univd:集视频转换、下载、编辑和压缩功能于一体的AI视频处理工具