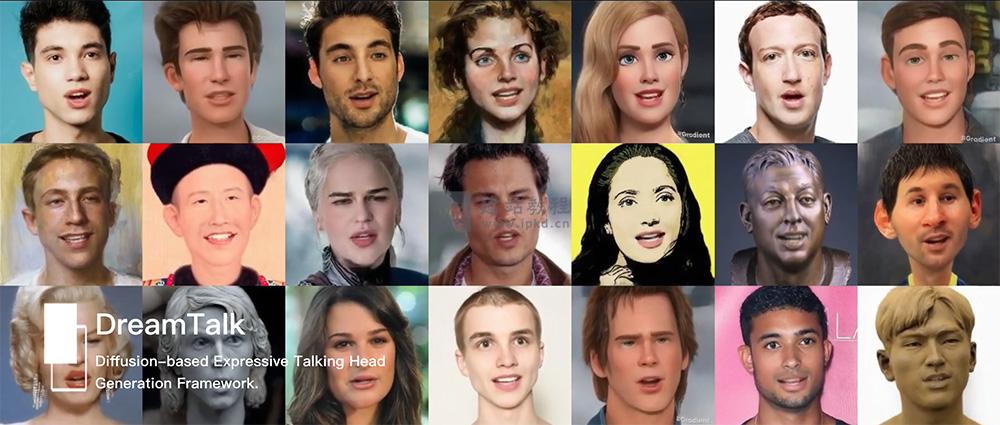

DreamTalk是由清华大学、阿里巴巴与华中科技大学联合开发的扩散模型驱动面部动画生成框架,核心能力是让静态人物照片“开口说话”,支持匹配歌曲、多语言语音、嘈杂音频等多种声音类型,生成的唇部动作与表情风格高度自然逼真,打破了传统照片说话技术对纯净音频、表情参考的依赖。

DreamTalk核心技术架构:

1、扩散降噪网络:高质量面部运动生成核心:

作为框架的核心组件,基于扩散模型原理逐步去除噪声数据,在多样化表情变化中,稳定合成与音频精准同步的高质量面部运动轨迹。无论是平缓叙述还是情绪激烈的语音,都能生成连贯、不僵硬的面部动态,保障动画的真实质感。

2、风格感知唇部专家:精准还原说话风格与唇形同步:

专注优化唇部动作的表现力与准确性,通过深度分析音频中的语调、节奏、情绪等说话风格特征,引导唇部运动与语音精准匹配。既解决了“口型对不上声音”的问题,又能还原不同说话者的独特风格,让生成动画更具个性化。

3、扩散风格预测器:摆脱表情参考依赖:

创新性引入基于扩散模型的风格预测器,无需额外输入表情参考视频或文本描述,可直接从音频信号中预测目标表情风格。这一设计大幅降低了使用门槛,即使没有专业标注数据,也能生成符合音频情绪的自然面部表情。

DreamTalk核心应用场景:

1、多样化说话人脸生成:

输入任意人物照片与音频(歌曲、多语言语音、嘈杂环境音均可),快速生成具有对应表情风格的说话动画,适用于短视频创作、虚拟主播素材制作等场景。

2、影视与虚拟角色制作:

在影视后期、虚拟角色开发中,为静态角色形象赋予逼真的表情与唇形动作,大幅降低动作捕捉的成本,提升虚拟角色的交互真实感。

3、人机交互场景优化:

应用于智能终端、服务机器人等设备,让虚拟交互界面的人物形象具备自然的面部表情与唇部运动,提升人机交互的亲切感与沉浸感。

DreamID-Omni虚拟数字人模型,清华 × 字节跳动统一可控以人为中心音视频生成框架

Ctrl-World模型使用入口,厘米级轨迹精度、0.986的策略评估一致性及0.93的深度准确性

Ultralytics官网:一个轻量化开源计算机视觉与AI深度学习框架

FastBuildAI:一款面向AI开发者、创业者开源零代码AI应用开发框架

UniVG:百度团队研发的AI视频生成系统,支持文本、图像组合输入

标签: AI开源项目, 华中科大, 开放式扩散模型, 清华大学, 阿里巴巴框架

上面是“DreamTalk:清华联合阿里、华中科大研发,音频驱动的高逼真照片说话框架”的全面内容,想了解更多关于 AI项目和框架 内容,请继续关注web建站教程。

当前网址:https://m.ipkd.cn/webs_27441.html

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

php查询mysql数据库如何实现排序

php查询mysql数据库如何实现排序 活动汪:一个为活动行业从业者提供一站式的职业服务

活动汪:一个为活动行业从业者提供一站式的职业服务 Blend APP最新版

Blend APP最新版 Lookie APP最新版

Lookie APP最新版