MMBench是一款多模态基准测试工具,由上海人工智能实验室、南洋理工大学、香港中文大学、新加坡国立大学及浙江大学联合研发。该基准构建了一套从感知到认知的逐级细分评估流程,覆盖20项细粒度能力维度,数据集包含约3000道单项选择题,均源自互联网及权威基准数据集。

MMBench突破常规一问一答、基于规则匹配提取选项的评测模式,创新性采用循环打乱选项的方式验证模型输出一致性,并依托ChatGPT将模型回复精准匹配至对应选项。其任务类型覆盖视觉问答、图像描述生成等多类场景,结合多维度综合指标,可实现对多模态模型的全面性能评估。MMBench配套的排行榜直观呈现不同模型的任务表现,助力研究者与开发者洞悉多模态技术发展水平,推动领域技术迭代。

MMBench核心功能:

1、细粒度能力评估:

将多模态能力拆解为感知、推理等多个维度,针对性设计任务问题,实现模型能力的精细化评估。

2、大规模多模态数据集:

提供约3000道多项选择题,覆盖20种能力维度,支撑模型在多场景下的性能测试。

3、创新循环评估策略:

通过多次循环推理验证模型输出稳定性,有效降低评测噪声,输出更可靠的评估结果。

4、多语言支持:

同步提供英文、中文双版本数据集,满足不同语言环境下的模型评估需求。

5、数据可视化功能:

支持数据样本可视化展示,帮助用户快速理解数据结构与内容构成。

6、标准化评估工具:

配套官方评估工具VLMEvalKit,支持多模态模型标准化评估,可直接用于提交测试结果以获取准确率数据。

7、基准测试与排行榜:

通过排行榜展示各模型在MMBench数据集上的性能表现,为研究者提供直观的技术参考。

MMBench使用流程:

1、安装依赖工具:

安装官方推荐的评估工具VLMEvalKit及其他必要的工具库,为后续操作搭建环境。

2、下载目标数据集:

访问[MMBench官方GitHub仓库](https://github.com/open-compass/mmbench/),按需下载VLMEvalKit格式或Legacy格式的数据集,例如MMBench-Dev数据集。

3、加载与浏览数据:

调用VLMEvalKit提供的脚本,完成数据样本的加载与查看,快速熟悉数据特征。

4、执行模型推理:

采用目标多模态模型对数据集进行推理,以llava_v1.5_7b模型为例,运行推理命令后,结果将自动保存为Excel文件(如llava_v1.5_7b/MMBench_DEV_EN.xlsx)。

5、评估模型性能:

使用VLMEvalKit工具,基于MMBench标准对模型预测结果进行评估,自动计算准确率等核心指标。

6、提交测试结果:

– 基于测试集数据完成推理,生成对应的预测结果文件(如llava_v1.5_7b/MMBench_TEST_EN.xlsx);

– 登录MMBench领先榜平台,上传预测结果文件;

– 平台将自动计算并展示模型在各能力维度的具体性能表现。

MMBench应用场景:

1、模型性能评估:

提供全面的多模态基准测试平台,对视觉语言模型在不同任务、能力维度的表现进行细粒度评测,帮助研发人员明确模型优劣,为模型架构优化提供方向指引。

2、学术研究支持:

为研究人员提供高质量数据集,支撑新模型的开发与验证工作,助力多模态技术前沿研究突破。

3、工业应用开发:

协助企业评估、筛选适配产品需求的多模态模型,保障模型在实际应用中的性能与稳定性,提升产品市场竞争力。

4、教育与培训:

可作为教学资源,帮助学生及研究人员掌握多模态模型评估方法与应用逻辑,通过实践项目与课程练习深化对技术的理解与应用能力。

5、跨领域应用拓展:

数据集覆盖文化、科学、医疗等多个领域,例如依托CCBench(中国文化相关基准测试)可评估模型的文化领域表现,助力文化研究与跨文化交流推进。

DeepGen 1.0模型使用入口,浙江大学等联合推出的轻量级统一多模态模型,仅50亿参数

Qwen3.5模型使用入口,开源版本Qwen3.5-397B-A17B采用创新混合架构

TeichAI官网使用入口,面向企业与开发者的一站式人工智能能力平台

Kimi k1.5:MoonshotAI研发的强化学习优化新一代多模态语言模型

HunyuanCustom:支持文本、图像、音频、视频多模态输入的多模态定制视频生成框架

标签: AI模型评测, 上海人工智能实验室, 南洋理工大学, 多模态AI模型, 大模型评测体系, 新加坡国立大学, 浙江大学, 香港中文大学

上面是“MMBench:一款由高校等联合研发多模态基准测试工具”的全面内容,想了解更多关于 AI项目和框架 内容,请继续关注web建站教程。

当前网址:https://m.ipkd.cn/webs_28234.html

声明:本站提供的所有资源部分来自互联网,如果有侵犯您的版权或其他权益,请发送到邮箱:admin@ipkd.cn,我们会在看到邮件的第一时间内为您处理!

jquery增加父标签用什么方法(wrap)

jquery增加父标签用什么方法(wrap) Spark Chemistry-X1-13B:科大讯飞开源的化学专业大语言模型

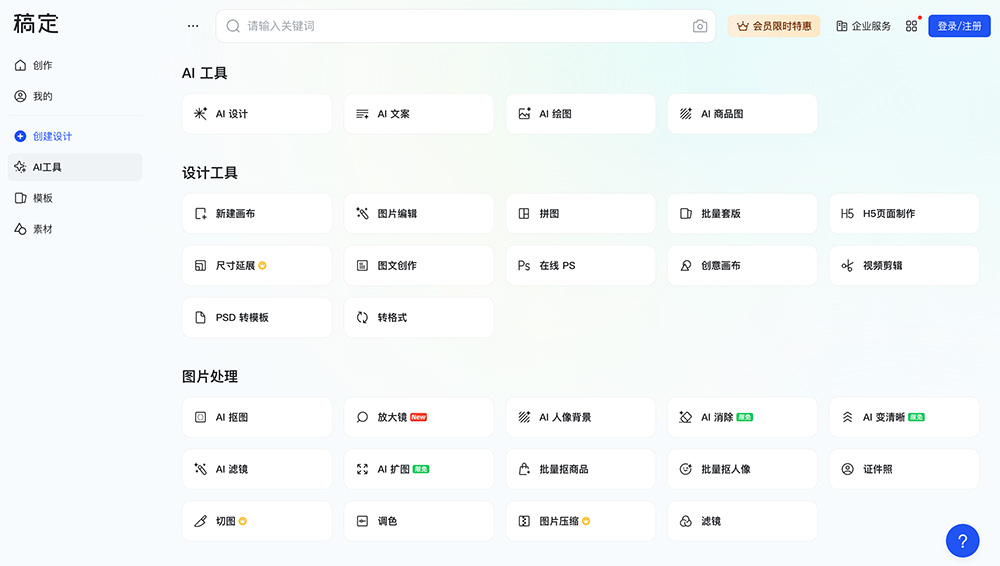

Spark Chemistry-X1-13B:科大讯飞开源的化学专业大语言模型 一键智能抠图,高效处理电商、证件照等AI插件——稿定AI抠图

一键智能抠图,高效处理电商、证件照等AI插件——稿定AI抠图 Website Cloner:高效网站克隆工具,数分钟复刻网站布局与功能

Website Cloner:高效网站克隆工具,数分钟复刻网站布局与功能